No te imaginabas que la codificación binaria fuera tan importante en el mundo actual, aquí te explicamos por qué.

La codificación binaria y su relevancia en el mundo actual

La informática y la electrónica son disciplinas que han evolucionado de manera exponencial en las últimas décadas, y en gran parte, esto se debe al desarrollo de la codificación binaria. Esta técnica, que utiliza únicamente los símbolos 0 y 1 para representar información, ha revolucionado la manera en que se transmiten y almacenan datos en la era digital.

Breve historia de la codificación binaria

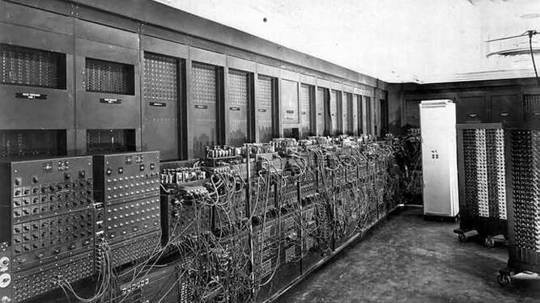

La codificación binaria tiene sus raíces en los trabajos de los matemáticos George Boole y Gottfried Wilhelm Leibniz, quienes en el siglo XVII desarrollaron los fundamentos de la lógica binaria. Sin embargo, la codificación binaria tal y como la conocemos hoy en día, comenzó a utilizarse en la década de 1940 con la invención del primer ordenador electrónico, el ENIAC. Desde entonces, la codificación binaria se ha convertido en una técnica fundamental para el procesamiento, transmisión y almacenamiento de información en todo tipo de sistemas digitales.

Fotografía del ENIAC el primer ordenador electrónico. Diario de Sevilla

En términos simples, la codificación binaria es una técnica que utiliza sólo dos símbolos, el 0 y el 1, para representar información. En lugar de utilizar los números decimales tradicionales (0-9), se utilizan combinaciones de ceros y unos para representar caracteres, números, imágenes y cualquier tipo de datos. La base de la codificación binaria radica en el sistema numérico binario, que utiliza potencias de dos para representar valores numéricos. Por ejemplo, el número binario 1011 representa el número decimal 11, ya que 1 x 2³ + 0 x 2² + 1 x 2¹ + 1 x 2⁰ = 8 + 0 + 2 + 1 = 11. De esta manera, cualquier información puede ser representada en formato binario y procesada por sistemas electrónicos.

Agrupaciones indispensables de la codificación binaria

En el mundo de la codificación binaria, las agrupaciones para almacenar información más conocidas son el bit, el byte, el kilobyte, el megabyte, el gigabyte, el terabyte y el petabyte.

El bit es la unidad más pequeña de información en un sistema digital, y representa un solo dígito binario (0 o 1). Los bytes, por otro lado, se componen de ocho bits y se utilizan para representar caracteres individuales, como letras y números.

El kilobyte (KB) equivale a 1,024 bytes, y se utiliza para medir el tamaño de archivos de texto y documentos. El megabyte (MB) equivale a 1,024 kilobytes, y se utiliza para medir el tamaño de archivos de audio, imágenes y videos de baja resolución. El gigabyte (GB) equivale a 1,024 megabytes y se utiliza para medir el tamaño de archivos de vídeo y software de computadora. El terabyte (TB) equivale a 1,024 gigabytes y se utiliza para medir el tamaño de grandes conjuntos de datos, como bases de datos y servidores de almacenamiento en la nube. Finalmente, el petabyte (PB) equivale a 1,024 terabytes y se utiliza para medir el tamaño de los conjuntos de datos más grandes, como los utilizados en la investigación científica y el análisis de big data.

Aplicaciones de la codificación binaria

La codificación binaria está presente en nuestras vidas cotidianas en más formas de las que podemos imaginar, cada vez que utilizamos un teléfono móvil, una computadora, una tableta o cualquier dispositivo electrónico, estamos interactuando con sistemas digitales que utilizan la codificación binaria para procesar y almacenar información. Desde el envío de mensajes de texto hasta la navegación en la web, la codificación binaria es esencial para el funcionamiento de todas estas herramientas.

Para los profesionales del sector, la comprensión de la codificación binaria es fundamental, los ingenieros que trabajan en áreas como la programación, la electrónica y las redes de computadoras, deben ser capaces de utilizar la codificación binaria de manera efectiva para diseñar y construir sistemas digitales avanzados. La codificación binaria también es crucial en la seguridad informática, ya que la criptografía utiliza algoritmos de codificación binaria para proteger la información confidencial.

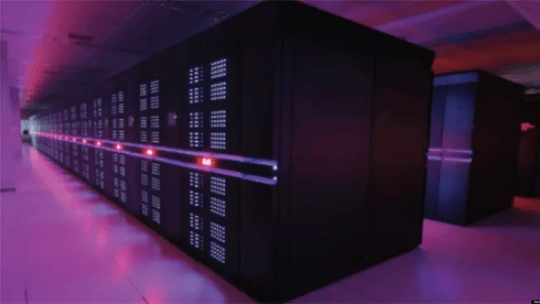

Fotografía del ordenador más potente del mundo a día de hoy, el Tianhe-2 . Computerhoy

En resumen, la codificación binaria es una tecnología fundamental que ha cambiado la forma en que interactuamos con el mundo digital, gracias a esta podemos almacenar y transmitir información de manera eficiente, y ha permitido el desarrollo de muchas de las tecnologías que usamos hoy en día como el BIM, desde smartphones y computadoras hasta sistemas de navegación GPS, incluso sistemas de gestión a todos los niveles.

Sin embargo, la evolución de la tecnología no se detiene aquí, con el crecimiento exponencial de la cantidad de datos que se producen cada día, la codificación binaria continuará evolucionando y desarrollándose para satisfacer las necesidades del futuro. Por lo tanto, es importante para los profesionales ingenieros mantenerse actualizados sobre los avances en este campo y desarrollar habilidades en áreas como la ciencia de datos y la inteligencia artificial, para estar preparados para las nuevas oportunidades que se presentarán en el mercado laboral. La codificación binaria es una tecnología que ha transformado el mundo, y su importancia en el futuro será aún mayor.